OpenAI anunció recientemente su modelo GPT-4o, un nuevo modelo insignia del motor que impulsa ChatGPT, su famoso chatbot impulsado por IA lanzado por primera vez en 2022. Este modelo más nuevo lleva la interacción persona-computadora a un nivel completamente nuevo al hacerla parecer más rápida y mucho más natural.

En GPT-4o, la ‘o’ significa ‘omni’, ya que combina texto, imagen y audio en un solo modelo. Si bien no hay mejoras en el frente de inteligencia y razonamiento con respecto al modelo GPT-4 Turbo, hay muchas actualizaciones nuevas. Está diseñado para proporcionar respuestas más rápidas y con un sonido más humano, e incluso puede simular emociones. También es considerablemente más rápido a la hora de comprender las entradas visuales y de audio. En esta inmersión profunda, analizaremos las funciones que ofrece GPT-4o y cómo revolucionará la forma en que interactuamos con los asistentes de IA. ¡Únase a nosotros y comencemos!

GPT-4o es significativamente más rápido

El modelo GPT-4o permite a ChatGPT aceptar entradas en diversas formas, incluido audio, texto, imágenes o sus combinaciones. También puede proporcionar respuestas en diferentes formatos. Sin embargo, lo más impresionante es la velocidad con la que proporciona respuestas.

Con el nuevo modelo, ChatGPT tarda sólo unos 320 milisegundos o incluso menos en responder a las entradas de audio, lo que se acerca al tiempo que tarda una persona en responder en una conversación. Además de esto, el rendimiento de GPT-4o es similar al de GPT-4 Turbo en lo que respecta al uso del inglés o la escritura de código.

También funciona mucho mejor cuando responde a entradas basadas en texto en idiomas distintos del inglés y es considerablemente más barato en la API ya que es mucho más eficiente que su predecesor.

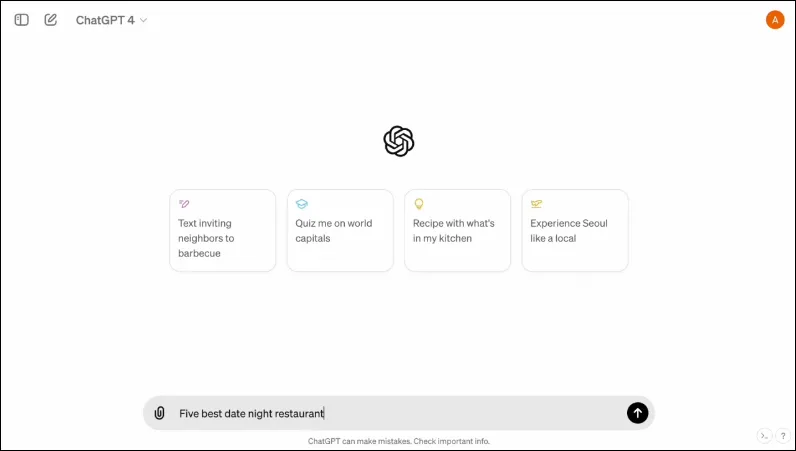

También cuenta con una nueva interfaz, diseñada para hacer la interacción más fácil y ordenada.

es multimodal

El modo de voz existente de ChatGPT consta de tres modelos. El primero acepta entradas basadas en texto y proporciona salida en el mismo formato, mientras que el segundo convierte la entrada de audio en texto, que ChatGPT toma para proporcionar salida basada en texto. El último modelo convierte texto en audio.

Sin embargo, este diseño resulta en una pérdida de información ya que el modelo no puede interactuar directamente con la entrada de audio o presentar la salida que tiene elementos emocionales. Con GPT-4o, OpenAI ha creado un único modelo multimodal que puede comprender diferentes tipos de entradas y procesar la salida requerida directamente.

Actualmente admite 50 idiomas y también estará disponible como API.

Puede simular emociones humanas

Cuando se anunció ChatGPT por primera vez, una de las mayores desventajas del chatbot de IA para muchas personas era que no podía proporcionar respuestas emocionales. Con GPT-4o, ChatGPT puede simular emociones humanas y proporcionar respuestas adecuadas que integren dichas emociones.

En las demostraciones compartidas por OpenAI, se puede ver al chatbot riendo, cantando e incluso mostrando sarcasmo cuando se le pide. Esto está muy por encima de lo que cualquier otro chatbot de IA puede hacer actualmente y hará que las interacciones del usuario sean mucho más agradables. Según OpenAI, el nuevo modelo permitirá a ChatGPT detectar también el estado de ánimo del usuario y proporcionar respuestas adecuadas basadas en esa información.

Combinada con la capacidad de utilizar información visual, la capacidad de proporcionar respuestas emocionales es una de las características más impresionantes que ofrece el nuevo modelo.

El nuevo modelo puede almacenar una mayor cantidad de información

Gracias a GPT-4o, ChatGPT ahora puede comprender mejor imágenes, como gráficos y fotografías, y también almacenar más información sobre el usuario. Esto también se traduce en respuestas que pueden contener fragmentos de texto más grandes, lo que puede resultar útil en varios casos de uso.

Por ejemplo, puedes pedirle al chatbot que traduzca fragmentos de texto más grandes ahora y puede ayudarte con la traducción en vivo. Dado que puede utilizar entradas visuales y de audio junto con entradas de texto, puede utilizarlo para recopilar información de capturas de pantalla, fotografías y otras imágenes.

Dado que puede almacenar una mayor cantidad de información sin que los usuarios tengan que repetirla, GPT-4o permite a los usuarios participar en conversaciones de ida y vuelta con el chatbot de IA. Con mayor información, los usuarios pueden esperar que las conversaciones sean más sofisticadas.

Salvaguardias en el nuevo modelo

Al igual que los modelos GPT existentes, el GPT-4o está diseñado teniendo en cuenta ciertas medidas de seguridad para garantizar la seguridad. Los datos de entrenamiento se filtraron y el comportamiento del modelo se perfeccionó después del entrenamiento. OpenAI también ha evaluado el modelo de IA en varios parámetros, como la ciberseguridad y la persuasión, para evitar incidentes no deseados.

Además de eso, los desarrolladores contaron con la ayuda de más de 70 expertos en diversos campos, como la desinformación y la psicología social, para identificar y mitigar los riesgos que podrían ocurrir o aumentar con el nuevo modelo. También continuarán monitoreando el uso del chatbot para detectar riesgos futuros y tomarán las medidas necesarias cuando sea necesario.

Para empezar, OpenAI sólo pondrá a disposición una selección limitada de ajustes preestablecidos de modelos de voz. También tendrá en cuenta los comentarios proporcionados por los usuarios para mejorar el modelo y garantizar una seguridad total.

Disponibilidad de GPT-4o

Hasta ahora, había dos versiones de ChatGPT disponibles: una versión gratuita que se ejecutaba en GPT 3.5 y una versión de pago que se ejecutaba en GPT 4.0 y costaba 20 dólares al mes. Este último puede acceder a un modelo de lenguaje más grande que le permite manejar mayores cantidades de datos.

GPT-4o estará disponible para usuarios gratuitos y de pago y se espera que se lance a los dispositivos en las próximas semanas. Estará disponible en dispositivos móviles a través de la aplicación existente, que se actualizará, y también estará disponible una nueva aplicación de escritorio macOS además de la versión web para usuarios de escritorio (la versión de Windows llegará más adelante este año).

Para distinguir entre usuarios gratuitos y pagos, OpenAI ofrecerá a los usuarios pagos cinco veces más capacidad que la que se ofrecerá a los usuarios gratuitos. Una vez que se te acabe el límite, volverás a ChatGPT 3.5.

El anuncio de OpenAI sobre GPT-40 llega justo un día antes de la Conferencia anual de desarrolladores de E/S de Google, donde se espera que Google haga sus propios anuncios relacionados con la IA. OpenAI también ha prometido que habrá más anuncios en camino, por lo que no puede haber duda de que la competencia entre los dos rivales apenas está comenzando a calentarse.

Si bien no sabemos cuándo OpenAI presentará más cambios en su modelo de IA, sí sabemos que GPT-4o se dirige a dispositivos que ejecutan ChatGPT a nivel mundial. Así que cruza los dedos y espera a que aparezca la actualización en tu dispositivo. ¡Hasta la proxima vez!

Deja una respuesta