En su conferencia anual I/O en California, Google hizo varios anuncios relacionados con la IA, incluidos nuevos modelos y actualizaciones de los existentes. Uno de los anuncios más interesantes fue el Proyecto Astra, un asistente multimodal que funciona en tiempo real y combina las capacidades de Google Lens y Gemini para brindarle información de su entorno.

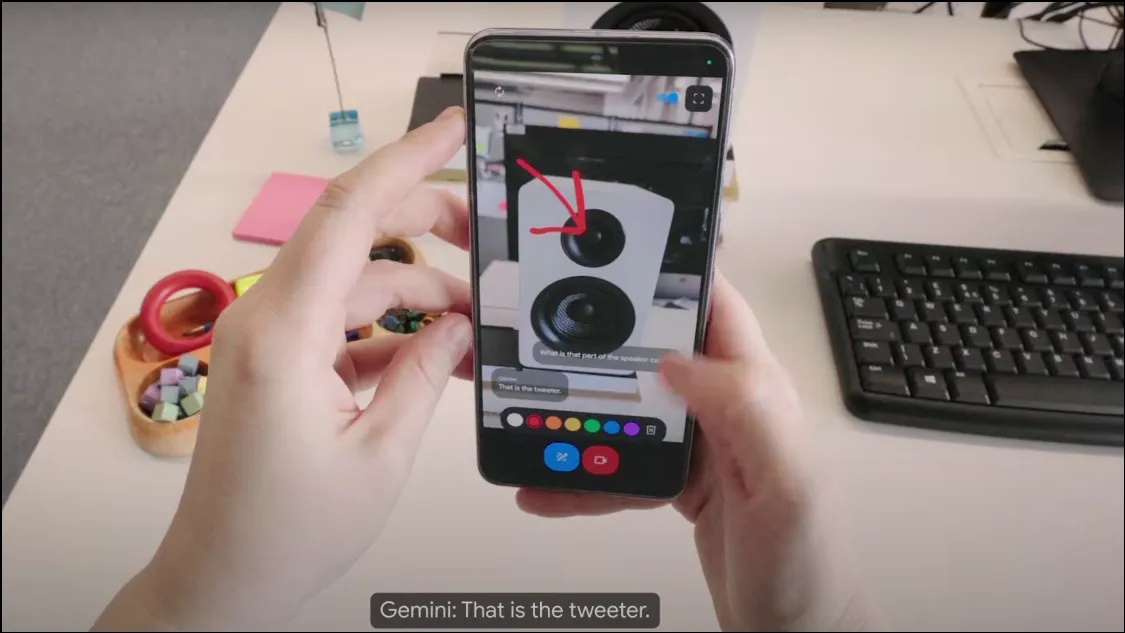

¿Cómo funciona el Proyecto Astra? En la conferencia, Google mostró una versión inicial del Proyecto Astra, que funciona como un chatbot basado en una cámara y puede recopilar información de su entorno utilizando la cámara de su dispositivo. Al ser un asistente de IA multimodal, puede utilizar audio, vídeo e imágenes como entradas y proporcionar la salida necesaria en función de ellos. Funciona con el modelo Gemini 1.5 Pro, lo que lo hace increíblemente potente.

El chatbot analiza objetos y alrededores en tiempo real y puede responder consultas muy rápidamente, lo que lo hace bastante similar a un asistente humano o al querido JARVIS de Tony Stark. El Proyecto Astra también funciona con dispositivos portátiles como gafas inteligentes, lo que significa que existe un gran potencial para que el chatbot de IA se integre en diferentes dispositivos.

El Proyecto Astra puede comprender mejor el contexto en el que se utiliza, procesar información más rápido y retenerla para recuperarla más rápidamente. Sus capacidades de habla también han mejorado mucho en comparación con las de los modelos Gemini anteriores, por lo que suena más natural y humano.

¿Qué puede hacer el Proyecto Astra? En la breve demostración que mostró Google, parece que hay muchas cosas que el Proyecto Astra puede ayudar a lograr. Puede observar y comprender objetos y ubicaciones a través de la lente de la cámara y el micrófono y brindarle información sobre ellos. Por ejemplo, puede simplemente apuntar su teléfono a un fragmento de código y discutirlo con el chatbot, o pedirle que identifique un objeto y su uso.

De manera similar, gracias a las capacidades de reconocimiento de ubicación, Project Astra puede proporcionar información sobre su localidad con solo echar un vistazo a su entorno. También puede retener la información que se le muestra, lo que puede resultar muy útil si desea localizar elementos extraviados, como se demostró en la demostración cuando ayudó al usuario a encontrar sus gafas.

También puedes pedirle ideas creativas al asistente de IA, como con Gemini en tu teléfono. Por ejemplo, puedes pedirle que te escriba la letra de una canción, el nombre de un grupo musical o cualquier otra cosa. Básicamente, el Proyecto Astra pretende ser un asistente universal de IA que puede brindarle información en tiempo real de una manera muy conversacional.

¿Cuándo estará disponible el Proyecto Astra? Hasta el momento, Google no ha hecho anuncios sobre la disponibilidad del Proyecto Astra. La versión que se muestra en la demostración es un prototipo inicial, pero Google insinuó que estas capacidades podrían integrarse en la aplicación Gemini existente en una etapa posterior.

Con el Proyecto Astra, Google se esfuerza por liderar la evolución de los asistentes de inteligencia artificial para que sean aún más útiles y fáciles de usar. Sin embargo, Google no es el único que persigue este objetivo. OpenAI también anunció recientemente GPT-4o, haciendo que su ChatGPT sea multimodal, mejorando sus capacidades y eficiencia. El nuevo modo de voz de ChatGPT (que se lanzará próximamente) también puede utilizar la entrada de vídeo de la cámara del dispositivo mientras interactúa con los usuarios.

En este momento, la diferencia entre los dos es que GPT-4o pronto estará disponible en todos los dispositivos que ejecutan ChatGPT, mientras que se espera que Project Astra esté disponible como Gemini Live en algún momento en el futuro, aunque actualmente no hay una fecha de lanzamiento. Dado que ChatGPT con tecnología GPT-4o estará disponible antes, queda por ver si el Proyecto Astra de Google será lo suficientemente bueno para rivalizar con el chatbot más popular de OpenAI.

Deja una respuesta