¿Recuerdas la demostración de voz para GPT-4o de OpenAI de hace un par de meses que sacudió al mundo con su parecido con un humano? Ya sabes, esa que podía hacerte olvidar por un rato que estabas hablando con una IA e incluso le recordó a mucha gente al personaje de inteligencia artificial de Scarlett Johansson en la película Her (y que también recibió críticas por ello).

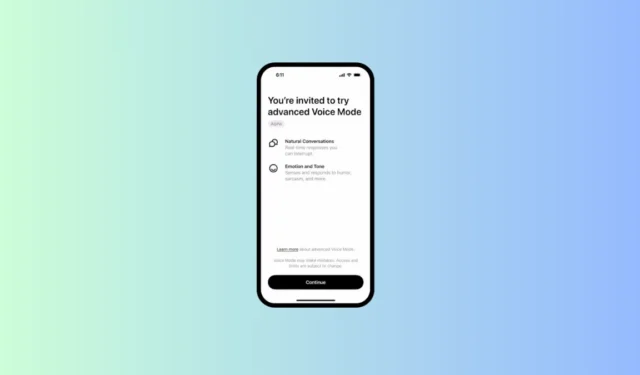

OpenAI finalmente está comenzando a implementarlo en Alpha para una pequeña cantidad de usuarios de ChatGPT Plus, como compartió la compañía en X. Si bien inicialmente, la compañía tenía planes de comenzar la implementación en junio, se retrasó por razones de seguridad y para garantizar que pudiera «alcanzar la barra [de OpenAI] para el lanzamiento». Como tal, la compañía estaba ocupada mejorando el modelo con un equipo de equipos rojos externos para que detectara y rechazara cierto contenido.

Estamos comenzando a implementar el modo de voz avanzado para un pequeño grupo de usuarios de ChatGPT Plus. El modo de voz avanzado ofrece conversaciones más naturales y en tiempo real, te permite interrumpir en cualquier momento y detecta y responde a tus emociones. pic.twitter.com/64O94EhhXK

– OpenAI (@OpenAI) 30 de julio de 2024

Ahora, algunos usuarios que pagan están empezando a tener acceso al modelo en su aplicación ChatGPT, pero por ahora, el acceso a la versión alfa será limitado. La empresa afirma que planea ofrecer acceso gradualmente a más usuarios y llevarlo a todos los usuarios que pagan más adelante en el otoño.

No parece haber ninguna forma de solicitar acceso al modo de voz avanzado. Si estás en la lista de los pocos usuarios que tendrán acceso a la versión alfa, recibirás un correo electrónico con instrucciones y una notificación en tu aplicación ChatGPT para probar el modo de voz.

El modo de voz avanzado solo podrá hablar con las 4 voces preestablecidas: Juniper, Amber, Cove y Breeze. Cabe destacar que OpenAI eliminó a Sky, la que sonaba como Scarlett Johansson poco después de que se lanzara la demostración en el evento de primavera y la actriz envió cartas a la empresa preguntando cómo se había hecho la voz (a lo que OpenAI aparentemente nunca respondió). Sky todavía no forma parte de la lista, al parecer.

ChatGPT-4o tampoco podrá proporcionar salidas en ninguna otra voz que no sea la predefinida para proteger la privacidad del usuario. También hay barandillas para bloquear solicitudes de contenido violento o con derechos de autor.

Si tienes acceso al modo de voz avanzado en tu aplicación ChatGPT, pruébalo. Si bien no podrá hacer todo lo que se muestra en las demostraciones hasta que también adquiera sus capacidades de visión, sigue pareciendo bastante impresionante, según algunos videos compartidos por los usuarios que tienen acceso.

Deja una respuesta