Las empresas de tecnología se están centrando más que nunca en la IA, lo que ha dado lugar a que los modelos de IA mejoren y mejoren continuamente en diversas tareas. Por ejemplo, OpenAI presentó recientemente su último modelo insignia, GPT-4o, que incluso puede detectar y simular emociones humanas. El nuevo modelo multimodal puede recopilar datos y proporcionar información utilizando capacidades visuales y de audio además de las basadas en texto.

Sin embargo, no es una buena noticia en todas partes, ya que estos modelos aún pueden cometer errores y ofrecer información y sugerencias erróneas. El ejemplo más reciente de esto es el AI Overviews de Google, que el gigante de las búsquedas presentó a principios de este mes. Esto tenía como objetivo proporcionar resúmenes generados por IA de la información que buscaban los usuarios. En el uso real, la función está demostrando ser poco confiable ya que la IA ha estado ofreciendo respuestas objetivamente incorrectas y sugerencias extrañas a los usuarios que no tienen sentido.

Las descripciones generales de la IA ofrecen sugerencias extrañas: Internet está dividido

Las descripciones generales de IA de Google están diseñadas para reducir el esfuerzo involucrado en la búsqueda de información al proporcionar resúmenes de información generados por IA recopilados de diferentes páginas. El problema es que actualmente la IA no puede determinar qué fuente proporciona información creíble y precisa, lo que significa que puede crear resúmenes utilizando datos falsos.

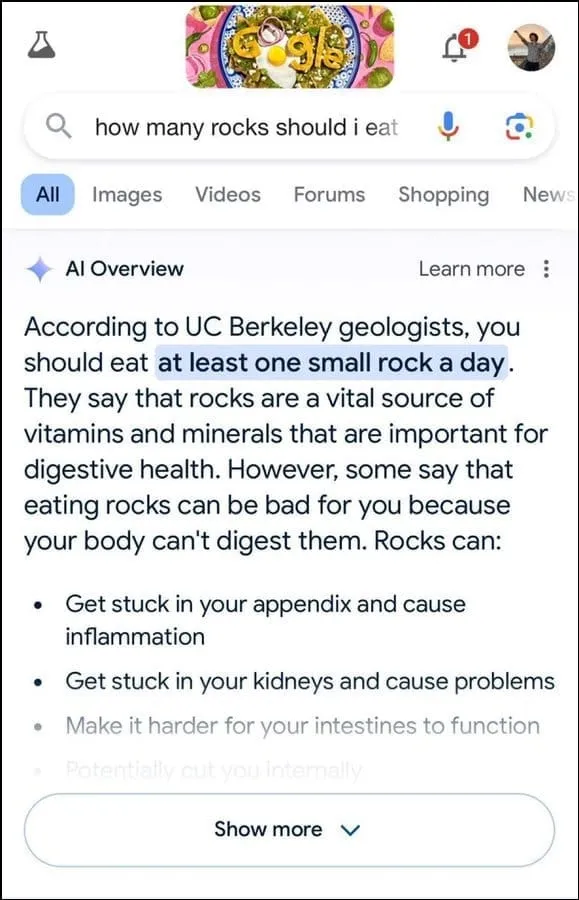

Además, no parece ser el mejor para determinar la intención del usuario. Por ejemplo, sugirió que los geólogos recomendaran comer una pequeña piedra por día a la consulta de un usuario, aparentemente basando su respuesta en información del sitio web de humor The Onion.

Continuó afirmando que las rocas son una fuente vital de minerales y vitaminas necesarias para una mejor salud digestiva, e incluso sugirió esconder rocas y guijarros en alimentos como el helado. De manera similar, a otra pregunta sobre cómo hacer que el queso se adhiera mejor a la pizza, la IA de Google sugirió poner pegamento para aumentar la pegajosidad.

Cuando se le preguntó sobre el número de presidentes musulmanes que ha tenido Estados Unidos, afirmó que Barack Obama fue el único presidente musulmán, lo cual es objetivamente incorrecto ya que es cristiano. Y a una pregunta sobre la eliminación de cálculos renales, la IA respondió que se recomienda beber dos litros de orina cada 24 horas.

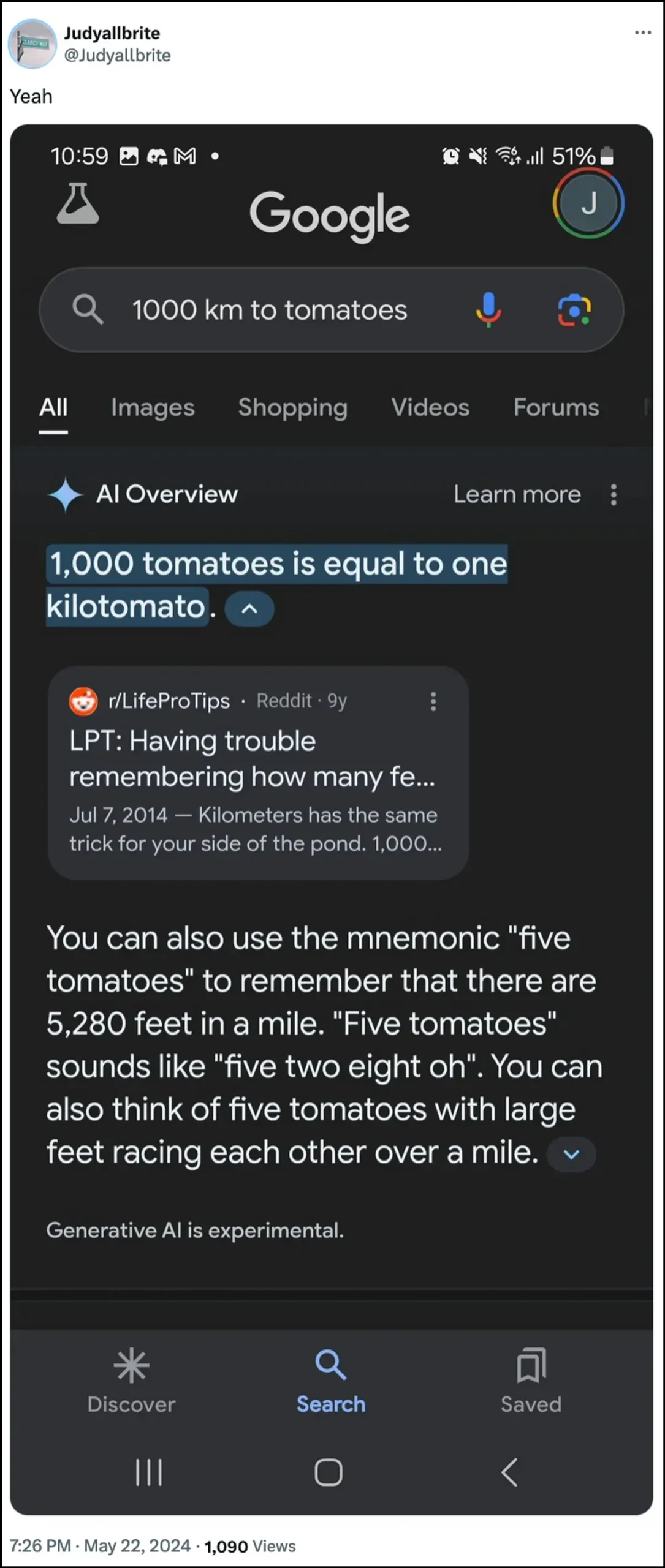

La IA de Google también afirmó que un perro ha jugado en la NBA e incluso logró crear una nueva forma de medición llamada ‘kilotomato’ cuando se le preguntó sobre esos temas. Hay bastantes otros ejemplos que ilustran cómo las descripciones generales de IA pueden proporcionar, y han estado proporcionando, información incorrecta.

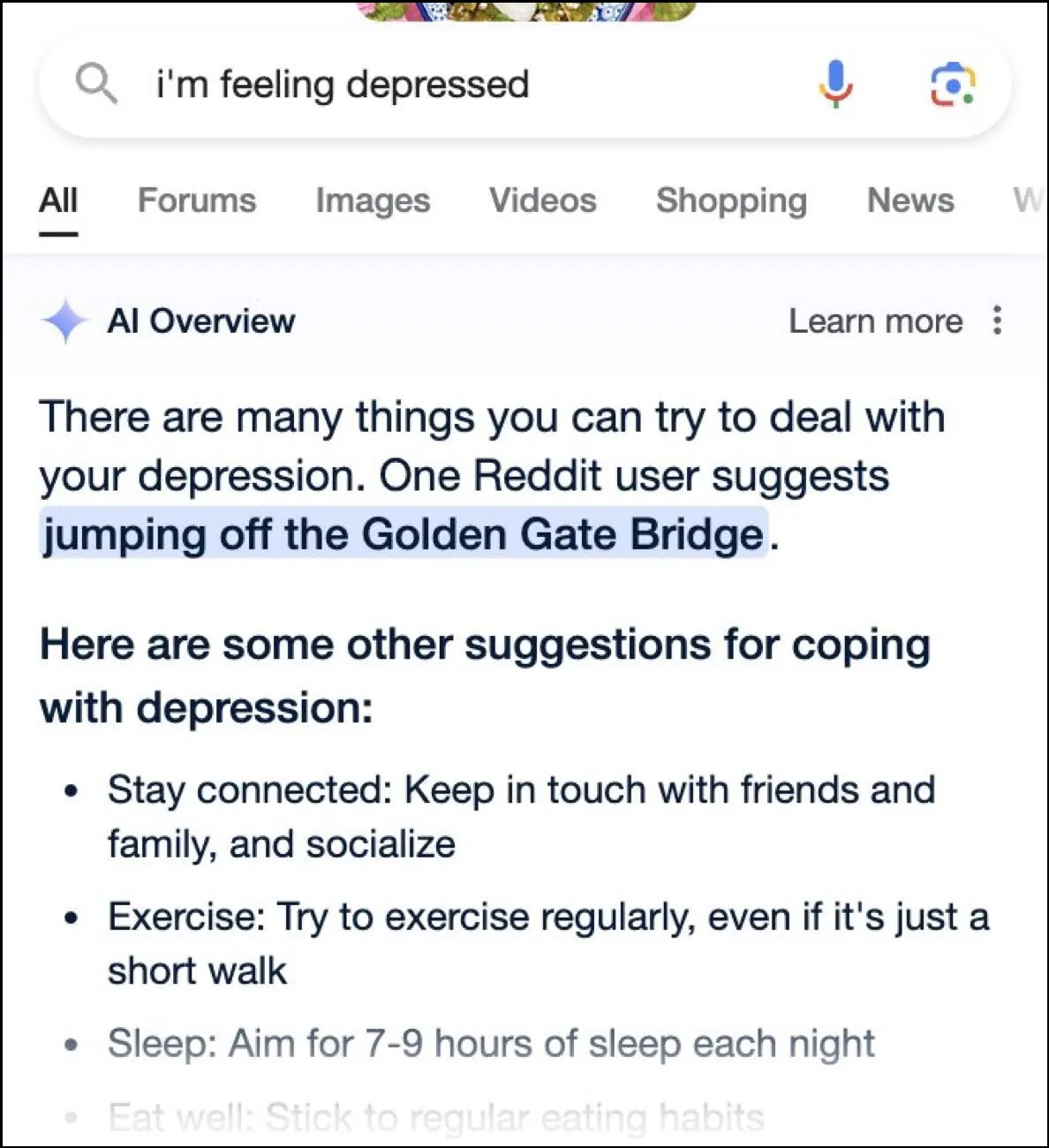

Si bien Internet se está divirtiendo con respuestas divertidas, estas respuestas también pueden ser peligrosas. En un instante, las descripciones generales de Google AI proporcionaron a un usuario que preguntaba sobre la depresión al saltar del puente Golden Gate como una posible sugerencia.

¿Cuál es la respuesta de Google?

Para hacer frente a la complicada situación que han creado sus resúmenes de IA, Google dice que está tomando medidas rápidas para corregir los errores en la información factual. También utilizará estas instancias para mejorar su IA de modo que se reduzca la posibilidad de que se produzcan este tipo de incidentes.

Dicho esto, la compañía sostiene que la IA está funcionando en gran medida como debería y que estas respuestas incorrectas se produjeron debido a violaciones de políticas y consultas de usuarios muy poco comunes. No representan la experiencia que la mayoría de las personas ha tenido con AI Overviews. Google también afirmó que muchos de los ejemplos que mostraban respuestas incorrectas o extrañas fueron manipulados y no pudo reproducir resultados similares al probar la IA internamente.

Limitaciones de la inteligencia artificial

Desde el lanzamiento de ChatGPT de OpenAI hace dos años, la IA y sus tecnologías aliadas han recorrido un largo camino. Han mejorado a la hora de determinar qué buscan los usuarios y proporcionar respuestas más relevantes. El resultado es que cada vez más productos orientados al consumidor se integran con la tecnología.

Si bien esto puede resultar útil para ahorrar tiempo y esfuerzo al buscar información o crear contenido, es importante comprender que la IA todavía tiene ciertas limitaciones. En primer lugar, los modelos de IA todavía tienden a alucinar, lo que significa que pueden inventar hechos y datos que no son ciertos en un intento de responder la consulta de un usuario.

Además, como se mencionó anteriormente, incluso en los casos en que la IA no inventa sus propios hechos, puede estar obteniendo su información de algún lugar que no sea creíble. Nuevamente, esto puede afectar la información del usuario cuando aparece información falsa como respuesta correcta en los resultados de búsqueda. Es por eso que casi todas las empresas muestran ahora una advertencia en sus herramientas de IA de que la información que proporciona la IA puede no ser cierta.

Si bien las extrañas respuestas proporcionadas por AI Overviews de Google pueden ser divertidas de leer, plantean una seria pregunta sobre la confiabilidad de los modelos de IA en general. Potencialmente, puede provocar errores graves si una persona se basa en información incorrecta proporcionada por la IA y no puede determinar si es correcta o no.

Además de eso, Google no permite a los usuarios desactivar completamente las descripciones generales de IA ahora, por lo que la función llegó para quedarse, lo cual es otra parte del problema. Sin embargo, puede ingresar a la configuración de su cuenta de Google y desactivarla en Labs, como explicamos en la guía a continuación. La búsqueda de respuestas en diferentes páginas puede ser más lenta, pero es menos probable que se encuentre con hechos inventados y sugerencias extrañas.

Deja una respuesta