Si desea ejecutar modelos de lenguaje grandes o LLM en su computadora, una de las formas más fáciles de hacerlo es a través de Ollama. Ollama es una poderosa plataforma de código abierto que ofrece una experiencia de inteligencia artificial personalizable y de fácil acceso. Facilita la descarga, instalación e interacción con varios LLM, sin necesidad de depender de plataformas basadas en la nube ni requerir conocimientos técnicos.

Además de las ventajas mencionadas anteriormente, Ollama es bastante ligero y se actualiza periódicamente, lo que lo hace muy adecuado para crear y administrar LLM en máquinas locales. Por lo tanto, no necesita servidores externos ni configuraciones complicadas. Ollama también es compatible con varios sistemas operativos, incluidos Windows, Linux y macOS, así como con varios entornos Docker.

Descarga e instalación de Ollama

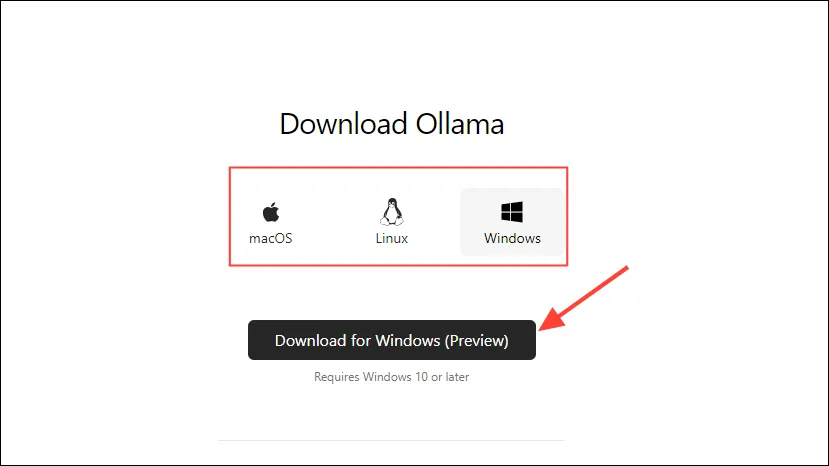

- Primero, visite la página de descarga de Ollama y seleccione su sistema operativo antes de hacer clic en el botón «Descargar».

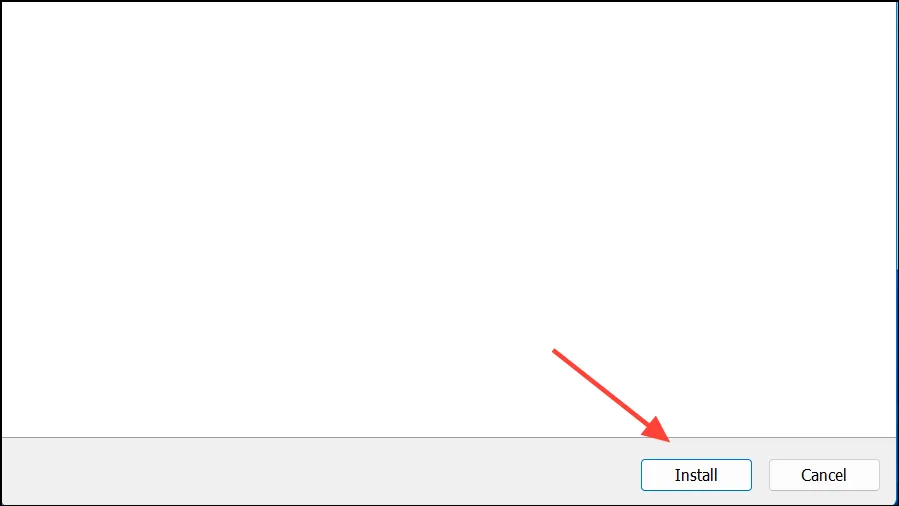

- Una vez que se complete la descarga, ábrala e instálela en su equipo. El instalador se cerrará automáticamente una vez que se complete la instalación.

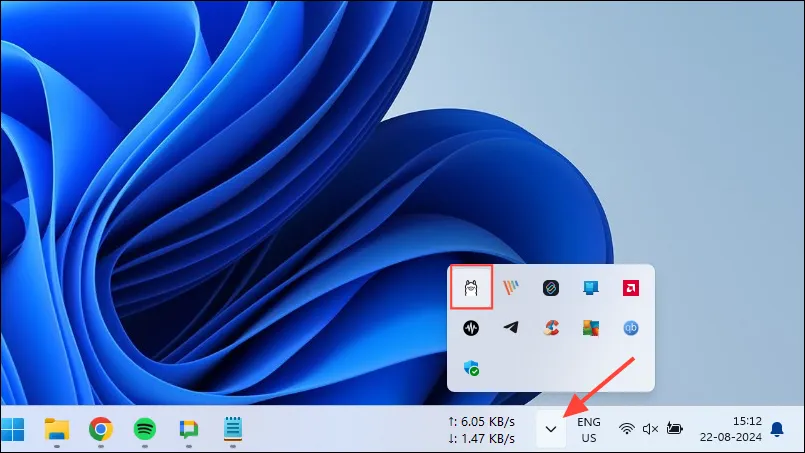

- En Windows, puedes comprobar si Ollama se está ejecutando o no haciendo clic en el botón de desbordamiento de la barra de tareas para ver los íconos ocultos.

Personalización y uso de Ollama

Una vez que Ollama esté instalado en tu computadora, lo primero que debes hacer es cambiar la ubicación donde almacena sus datos. De manera predeterminada, la ubicación de almacenamiento es , C:\Users\%username%\.ollama\modelspero como los modelos de IA pueden ser bastante grandes, tu unidad C puede llenarse rápidamente. Para hacerlo,

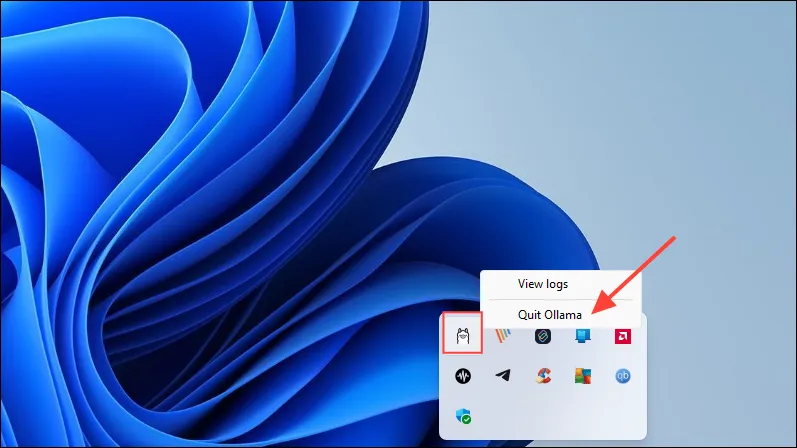

- Primero, haga clic en el ícono de Ollama en la barra de tareas y haga clic en “Salir de Ollama”.

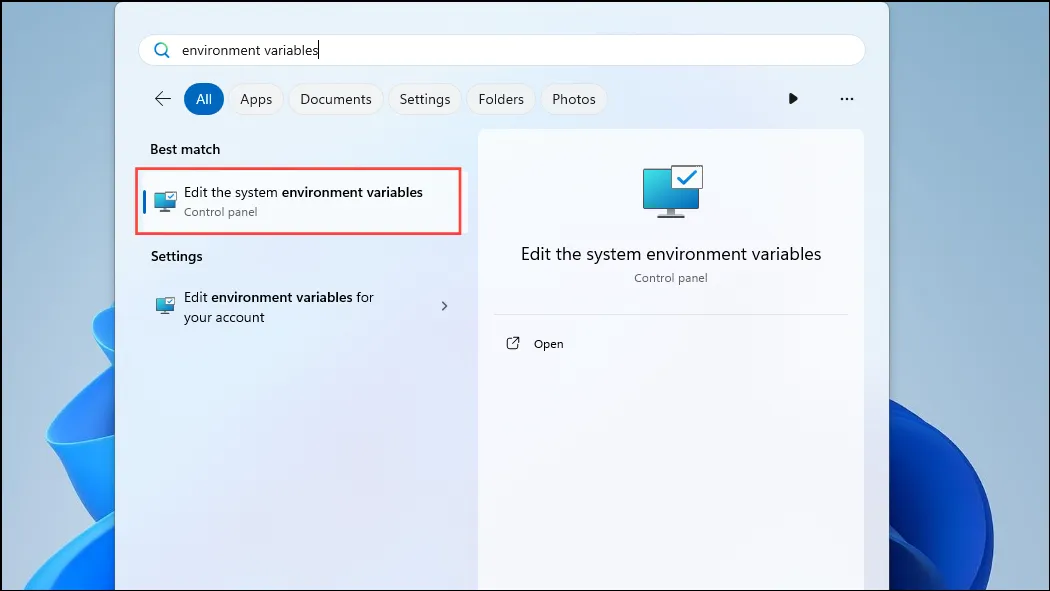

- Una vez que haya salido de Ollama, abra el menú Inicio, escriba

environment variablesy haga clic en ‘Editar las variables de entorno del sistema’.

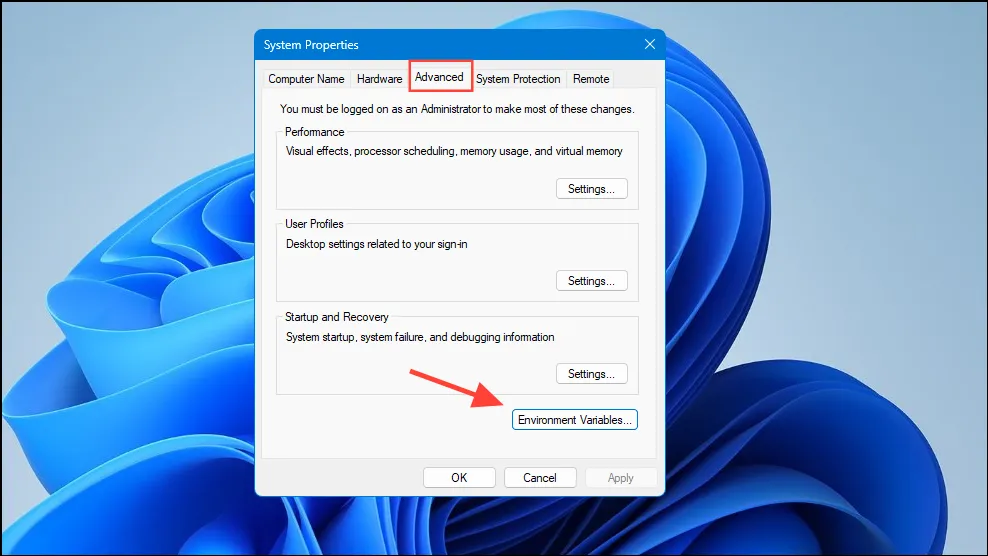

- Cuando se abra el cuadro de diálogo Variables del sistema, haga clic en el botón “Variables de entorno” en la pestaña “Avanzado”.

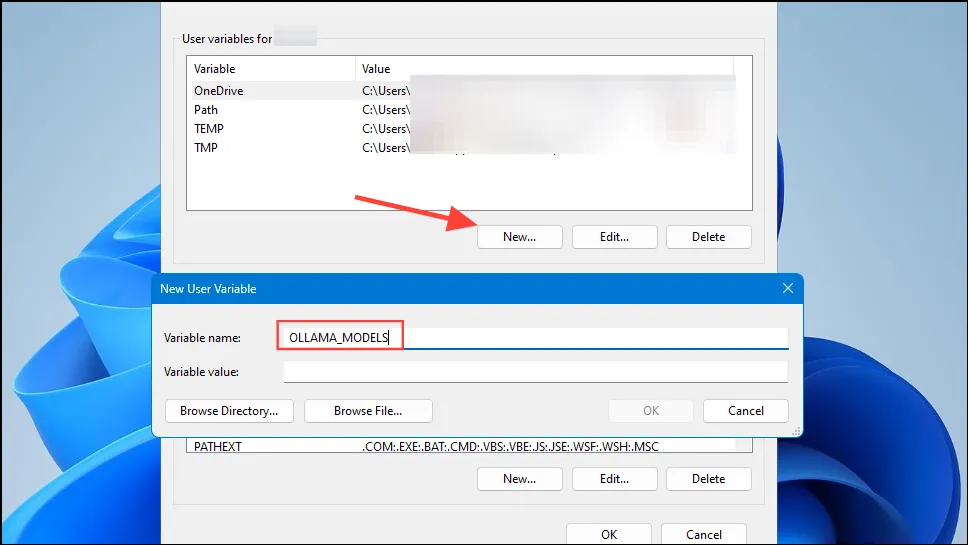

- Haga clic en el botón “Nuevo” para su cuenta de usuario y cree una variable nombrada

OLLAMA_MODELSen el campo “Nombre de la variable”.

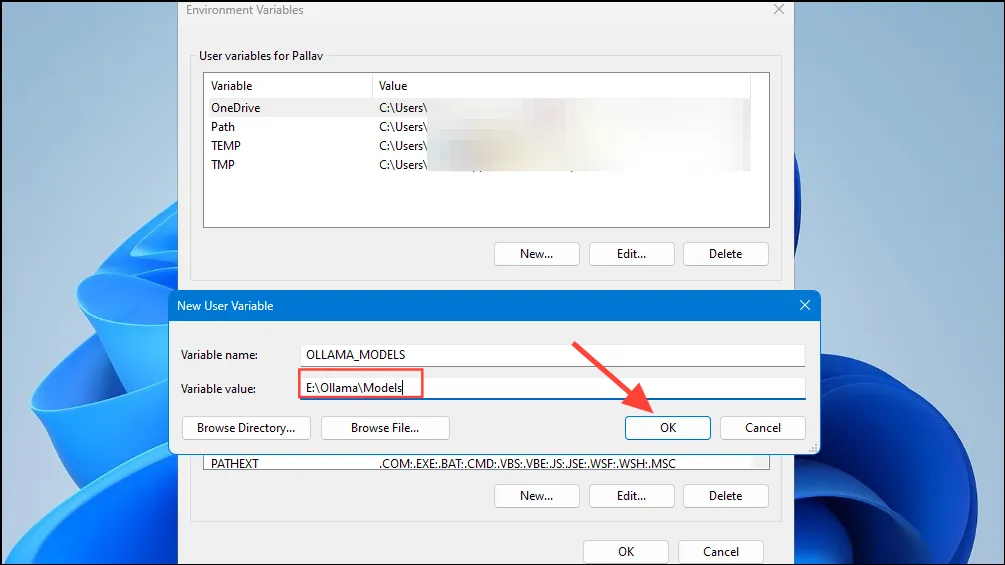

- A continuación, escriba la ubicación del directorio donde desea que Ollama almacene sus modelos en el campo «Valor de la variable». A continuación, haga clic en el botón «Aceptar» antes de iniciar Ollama desde el menú Inicio.

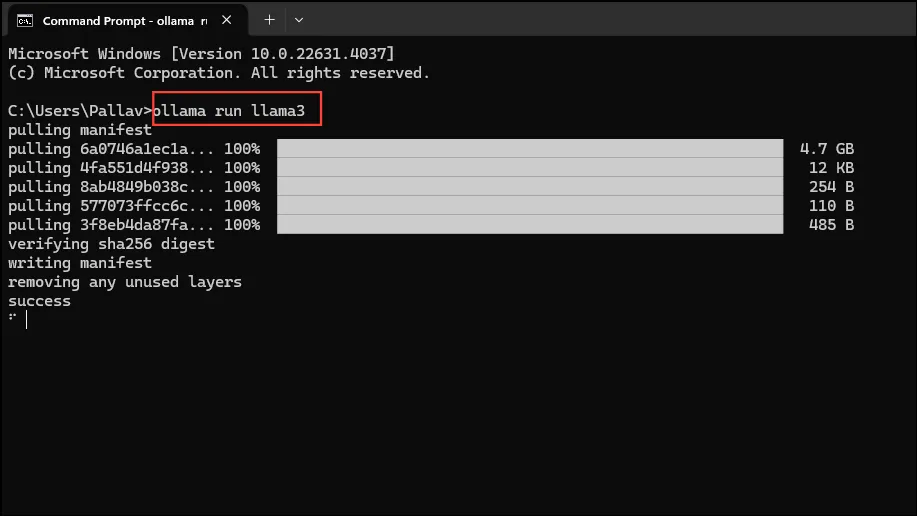

- Ahora está listo para comenzar a usar Ollama, y puede hacerlo con Llama 3 8B de Meta, el último modelo de inteligencia artificial de código abierto de la empresa. Para ejecutar el modelo, inicie una ventana del símbolo del sistema, PowerShell o la Terminal de Windows desde el menú Inicio.

- Una vez que se abra la ventana del símbolo del sistema, escriba

ollama run llama3y presione Entrar. El modelo ocupa cerca de 5 GB, por lo que descargarlo llevará tiempo.

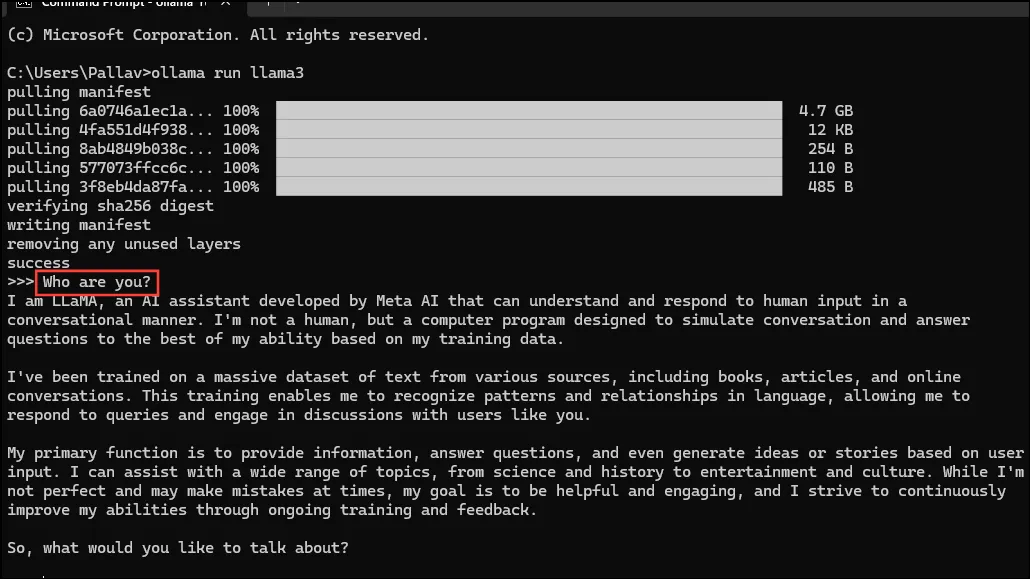

- Una vez que se complete la descarga, puedes comenzar a usar Llama 3 8B y conversar con él directamente en la ventana de línea de comandos. Por ejemplo, puedes preguntarle a la modelo

Who are you?y presionar Enter para obtener una respuesta.

- Ahora, puedes continuar la conversación y hacerle preguntas a los modelos de IA sobre diversos temas. Solo ten en cuenta que Llama 3 puede cometer errores y alucinar, por lo que debes tener cuidado al usarlo.

- También puedes probar otros modelos visitando la página de la biblioteca de modelos de Ollama. Además, hay varios comandos que puedes ejecutar para probar las diferentes funcionalidades que ofrece Ollama.

- También puede realizar varias operaciones mientras ejecuta un modelo, como configurar variables de sesión, mostrar información del modelo, guardar una sesión y más.

- Ollama también permite aprovechar los modelos de IA multimodales para reconocer imágenes. Por ejemplo, el modelo LLava puede reconocer imágenes generadas por DALLE-3 y describir imágenes en detalle.

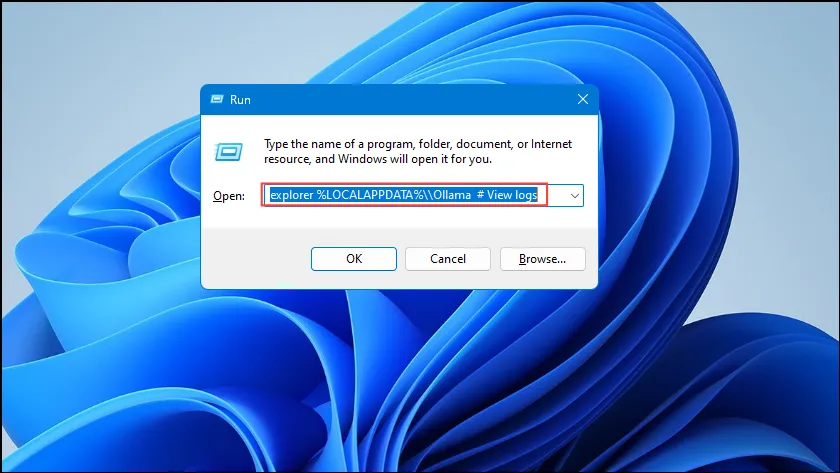

- Si se producen errores al ejecutar Ollama, puede consultar los registros para averiguar cuál es el problema. Utilice el

Win + Racceso directo para abrir el cuadro de diálogo Ejecutar y, a continuación, escribaexplorer %LOCALAPPDATA%\\Ollama # View logsdentro de él antes de pulsar Intro.

- También puede utilizar otros comandos como

explorer %LOCALAPPDATA%\\Programs\\Ollamayexplorer %HOMEPATH%\\.ollamapara comprobar los binarios, el modelo y la ubicación de almacenamiento de la configuración.

Cosas que debes saber

- Ollama detecta automáticamente tu GPU para ejecutar modelos de IA, pero en máquinas con varias GPU, puede seleccionar la incorrecta. Para evitar esto, abre el Panel de control de Nvidia y configura la Pantalla en «Solo GPU de Nvidia».

- Es posible que el modo de visualización no esté disponible en todas las máquinas y también esté ausente cuando conecta su computadora a pantallas externas.

- En Windows, puedes verificar si Ollama está usando la GPU correcta mediante el Administrador de tareas, que mostrará el uso de la GPU y te permitirá saber cuál está en uso.

- Si bien instalar Ollama en macOS y Linux es un poco diferente a hacerlo en Windows, el proceso de ejecutar LLM a través de él es bastante similar.

Deja una respuesta